La ética en la inteligencia artificial: El verdadero desafío de los seres humanos

La inteligencia artificial (IA) es una de las tecnologías más revolucionarias y prometedoras de nuestro tiempo. Su capacidad para procesar grandes cantidades de datos, aprender de la experiencia, resolver problemas complejos y generar nuevas soluciones ha abierto un mundo de posibilidades para mejorar la vida de las personas, las organizaciones y la sociedad.

Sin embargo, la IA también plantea una serie de desafíos éticos que nos obligan a reflexionar sobre el papel y la responsabilidad de los seres humanos en el desarrollo y el uso de estas tecnologías.

¿Qué criterios debemos seguir para diseñar, implementar y regular la IA? ¿Qué valores y principios debemos respetar y promover? ¿Qué riesgos y consecuencias debemos prevenir y mitigar?

Estas son algunas de las preguntas que se han planteado desde diferentes ámbitos académicos, profesionales, políticos y sociales, con el fin de establecer un marco ético que garantice que la IA sea beneficiosa, justa y sostenible para todos.

En este artículo te presentamos algunos de los principales temas y dilemas éticos que se derivan de la IA, así como algunas de las iniciativas y propuestas que se han elaborado para abordarlos.

Los temas éticos de la IA

La IA es una tecnología transversal que se aplica en diversos sectores y ámbitos, como la salud, la educación, la economía, la seguridad, el medio ambiente o el arte.

Cada uno de estos ámbitos tiene sus propias particularidades y desafíos éticos, pero también hay algunos temas comunes que afectan a la IA en general. Algunos de estos temas son:

La transparencia y la explicabilidad:

Se refiere a la capacidad de comprender cómo funciona la IA, cómo toma sus decisiones y qué criterios utiliza. La transparencia y la explicabilidad son fundamentales para generar confianza, responsabilidad y control sobre la IA. Sin embargo, muchos sistemas de IA son opacos o complejos, lo que dificulta su interpretación y verificación.

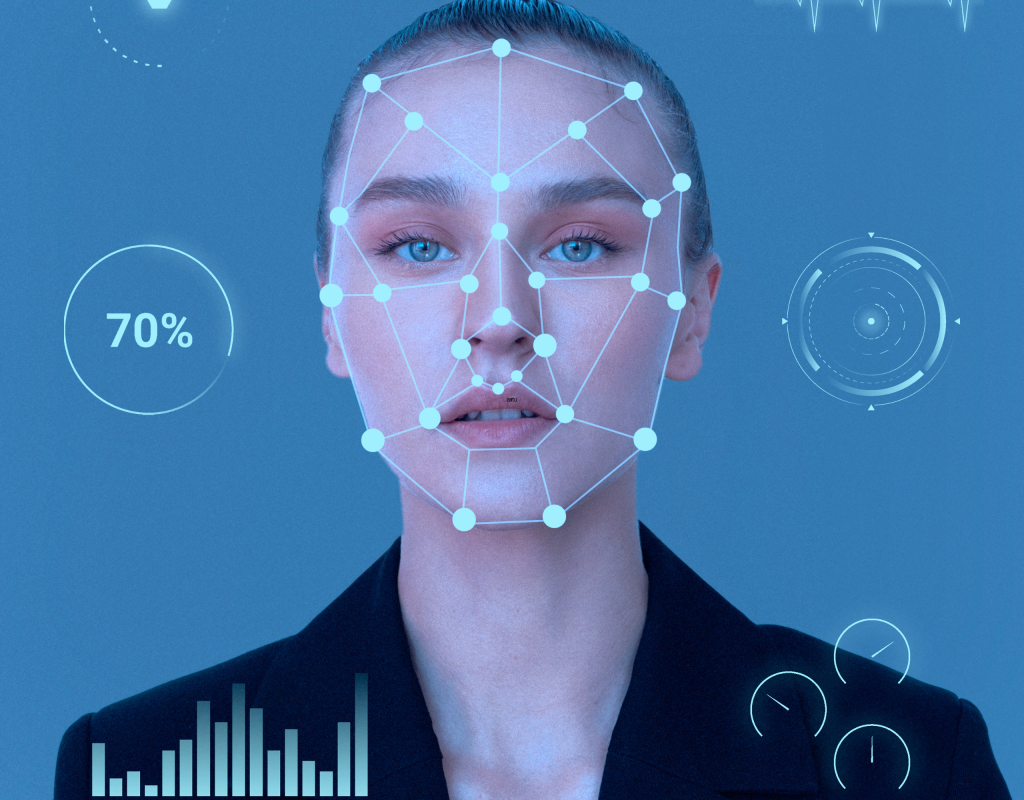

La equidad y la no discriminación:

Se refiere a la capacidad de evitar que la IA reproduzca o genere sesgos, prejuicios o desigualdades hacia determinados grupos o individuos.

La equidad y la no discriminación son esenciales para proteger los derechos humanos y la dignidad humana.

Sin embargo, muchos sistemas de IA pueden estar influenciados por los datos que utilizan, los algoritmos que emplean o los contextos en los que operan.

La seguridad y la fiabilidad:

Se refiere a la capacidad de garantizar que la IA funcione correctamente, sin causar daños o errores involuntarios o malintencionados.

La seguridad y la fiabilidad son imprescindibles para preservar el bienestar humano y social. Sin embargo, muchos sistemas de IA pueden ser vulnerables a fallos técnicos, ataques cibernéticos o usos indebidos.

La sostenibilidad y el impacto ambiental:

Se refiere a la capacidad de minimizar los efectos negativos de la IA sobre el medio ambiente y los ecosistemas. La sostenibilidad y el impacto ambiental son necesarios para asegurar el futuro del planeta y de las generaciones venideras.

Sin embargo, muchos sistemas de IA pueden consumir grandes cantidades de energía, recursos o materiales, o contribuir al cambio climático o a la pérdida de biodiversidad.

Los dilemas éticos de la IA

Además de los temas éticos generales, la IA también plantea una serie de dilemas éticos específicos que surgen cuando hay conflictos entre diferentes valores, principios o intereses.

Estos dilemas no tienen una solución única o definitiva, sino que requieren un análisis cuidadoso y una deliberación razonada. Algunos ejemplos de estos dilemas son:

- La privacidad versus el beneficio social: Se refiere al conflicto entre el derecho a proteger los datos personales frente al interés por utilizarlos para fines sociales. Por ejemplo, ¿hasta qué punto se puede compartir o analizar la información médica o genética de las personas para mejorar su salud o prevenir enfermedades?

- La autonomía versus el control: Se refiere al conflicto entre el derecho a tomar decisiones propias frente al interés por delegarlas en sistemas inteligentes. Por ejemplo, ¿hasta qué punto se puede confiar o depender de la IA para conducir un vehículo, elegir una carrera o encontrar una pareja?

- La creatividad versus la propiedad intelectual: Se refiere al conflicto entre el derecho a generar y proteger obras originales frente al interés por utilizarlas o reproducirlas con fines artísticos o comerciales. Por ejemplo, ¿hasta qué punto se puede reconocer o retribuir la autoría o el mérito de la IA que crea música, literatura o arte?

- La humanidad versus la inteligencia artificial: Se refiere al conflicto entre el derecho a preservar y potenciar las capacidades humanas frente al interés por mejorarlas o sustituirlas con tecnologías inteligentes. Por ejemplo, ¿hasta qué punto se puede modificar o ampliar el cerebro, el cuerpo o las emociones humanas con implantes, prótesis o interfaces cerebrales?

Las iniciativas y propuestas para la ética de la IA

Ante los desafíos éticos que plantea la IA, se han desarrollado diversas iniciativas y propuestas para establecer un marco ético que oriente y regule su desarrollo y uso.

Estas iniciativas y propuestas provienen de diferentes actores e instituciones, como organismos internacionales, gobiernos, empresas, universidades, organizaciones sociales o grupos de expertos.

Algunas de estas iniciativas y propuestas son:

La Recomendación sobre la Ética de la Inteligencia Artificial de la UNESCO:

Es el primer instrumento normativo mundial sobre el tema, adoptado por los 193 Estados miembros de la UNESCO en noviembre de 2021. S

u objetivo es proteger y promover los derechos humanos y la dignidad humana en el ámbito de la IA, basándose en el avance de principios fundamentales como la transparencia, la equidad, la responsabilidad o la solidaridad.

Los Principios Éticos para una IA Confiable de la Comisión Europea:

Son un conjunto de directrices éticas para el desarrollo y uso de la IA en Europa, elaboradas por un grupo de expertos independientes y publicadas por la Comisión Europea en 2019. Su finalidad es garantizar que la IA sea confiable, es decir, que sea legal, ética y robusta.

Los Principios Asilomar para el Beneficio Social de la IA:

Son una serie de principios éticos para el beneficio social de la IA, formulados por un grupo de científicos e investigadores reunidos en Asilomar (California) en 2017.

Su propósito es asegurar que la IA sea alineada con los valores humanos y que sea segura y beneficiosa para todos. Para ello, plantean 23 principios éticos que abarcan aspectos como la investigación, los valores, la ética, las leyes o las políticas públicas.

La ética en la inteligencia artificial es el verdadero desafío de los seres humanos.

No se trata solo de una cuestión técnica o científica, sino también de una cuestión moral y social. La IA nos ofrece grandes oportunidades para mejorar nuestro mundo, pero también nos plantea grandes responsabilidades para hacerlo bien.

Por eso, es necesario reflexionar sobre los valores y principios que queremos que guíen nuestra relación con esta tecnología, así como sobre las acciones y medidas que debemos tomar para asegurar su uso ético.

Llamado a la acción: ¿Qué te ha parecido este artículo? ¿Estás de acuerdo con los temas y dilemas éticos que hemos presentado? ¿Qué otras iniciativas y propuestas conoces sobre la ética de la IA? Te invitamos a dejar tu opinión en los comentarios y a compartir este artículo en tus redes.